Ausführen des DeepSeek R1-Destillationsmodells auf InHand AI Edge-Computern

DeepSeek R1, ein Open-Source-KI-Modell, definiert die Effizienz und Leistung in der KI-Community neu. Seine hochmoderne Technologie zur Wissensdestillation verwandelt komplexe Modelle in leichtgewichtige Kraftpakete, die erstklassige Inferenzfunktionen bieten. Diese Kombination aus Open-Source-Zugänglichkeit und schlankem Design senkt die Hürden für den Einsatz von KI und eröffnet neue Möglichkeiten für Edge Computing.

Das KI-Technologie-Team von InHand Networks hat soeben das destillierte Modell DeepSeek R1 erfolgreich auf dem EC5000-Serie AI-Edge-Computer. Diese Leistung bestätigt das leistungsstarke Potenzial von leichtgewichtigen Edge-Geräten für KI-Inferenzaufgaben. Im Vergleich zu herkömmlichen Cloud-basierten Implementierungen macht Edge-KI-Computing Hochleistungsserver überflüssig und ermöglicht Echtzeit-Inferenzen in Umgebungen mit geringem Stromverbrauch. Dies macht KI-Lösungen attraktiver flexibel, sicher und effizient für Anwendungen wie industrielle Qualitätskontrolle, intelligenter Transport und Telemedizin.

Ausführen des DeepSeek R1 Distilled Model auf dem EC5000 AI Edge Computer

Mit nur wenigen Schritten können Sie das destillierte DeepSeek R1-Modell auf den Edge-Computern der EC5000-Serie einsetzen:

Schritt 1: Installieren Sie das Jetson Containers Toolkit von Nvidia

(Dieses Toolkit hilft bei der effizienten Verwaltung und Bereitstellung von containerisierten KI-Anwendungen).

Führen Sie die folgenden Befehle aus, um das Jetson Containers Toolkit herunterzuladen und zu installieren:

Schritt 2: Nvidia JetPack Toolkit installieren

(JetPack bietet wichtige Treiber und Bibliotheken für die Ausführung von KI-Workloads auf Jetson-Geräten).

Um das JetPack-Toolkit zu installieren, führen Sie aus:

Warten Sie vor den nächsten Schritten etwa eine Minute.

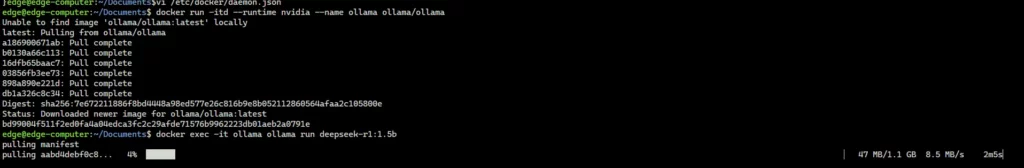

Schritt 3: Ollama Container herunterladen und ausführen

docker run -itd --runtime nvidia --name ollama ollama/ollama

Schritt 4: Herunterladen und Ausführen des DeepSeek R1 Distilled Model mit Ollama

Referenz: DeepSeek R1 Bibliothek

Wählen Sie das entsprechende DeepSeek R1-Destillationsmodell aus Ollamas Bibliothek und installieren es automatisch über die Befehlszeile. Zum Beispiel, um die DeepSeek-R1-Distill-Qwen-1.5B Modell, ausführen:

Sie können deepseek-r1:1.5b durch jeden anderen verfügbaren Modellnamen aus Ollama's Suchseite.

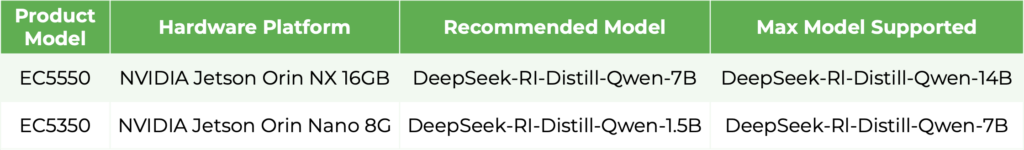

Die nachstehende Tabelle zeigt die von den EC5000-Edge-Computern unterstützten destillierten DeepSeek R1-Modelle.

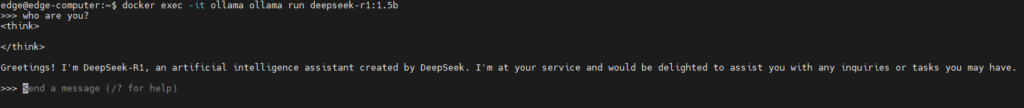

Mit dem Modell interagieren

Sobald das Modell läuft, können Sie direkt über die Befehlszeile mit ihm interagieren, was Echtzeitabfragen und Antworten ermöglicht, die auf Ihre spezifischen KI-Anwendungen zugeschnitten sind.

Anmerkung: Ersetzen Sie "deepseek-r1:1.5b" durch den Namen des Modells, das Sie entsprechend Ihren Anforderungen verwenden möchten.

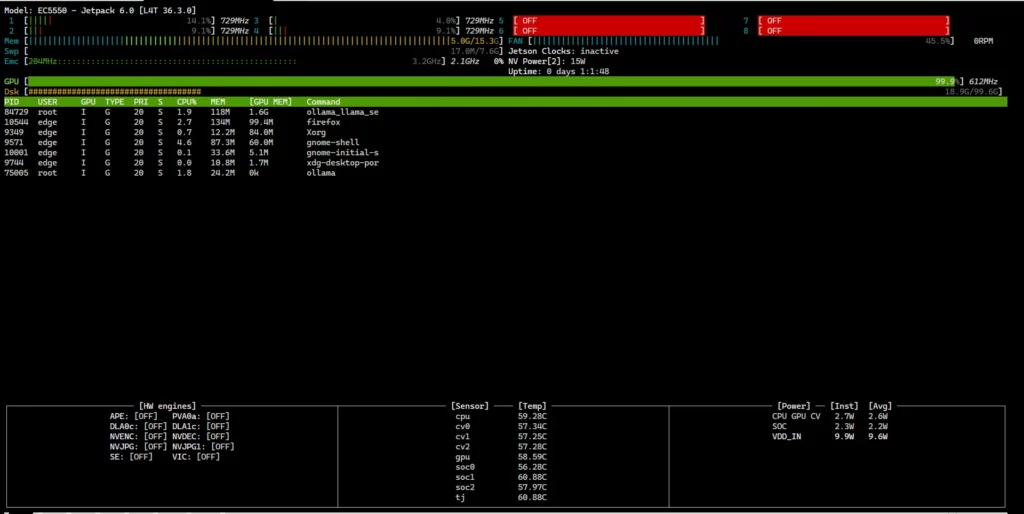

Überwachung der EC5000-Hardware-Auslastung

Zur Überprüfung der CPU-, GPU- und Speichernutzung Ihres EC5000 Edge-Computers in Echtzeit, verwenden Sie die jtop Befehl:

Dadurch wird der aktuelle Hardwarestand des Geräts angezeigt.

Das ist wichtig: Der Befehl jtop muss mit Root-Rechte.

Zusätzliche Hinweise

- Neben dem destillierten Modell DeepSeek R1 unterstützen die Edge-Computer der EC5000-Serie auch andere Open-Source-LLMs (Large Language Models), wie z. B. LLaMA 3.

- Ausführen von LLMs auf EC5000-Edge-Computern über Ollama ist nicht die einzige Methode, die zur Verfügung steht - je nach Ihren spezifischen Anforderungen können auch andere Einsatzmöglichkeiten geprüft werden.

Der Einsatz des destillierten Modells von DeepSeek R1 auf der EC5000-Serie demonstriert die nahtlose Integration modernster KI mit Edge-Computing-Hardware und ebnet den Weg für eine neue Ära leichtgewichtiger, leistungsstarker Edge-KI.

Mit der Weiterentwicklung der Destillationstechnologie können Unternehmen diese Fortschritte nutzen, um private KI-Dienste aufzubauen, die Rechenkosten zu senken und gleichzeitig die Datensicherheit zu gewährleisten. Dieser Fortschritt eröffnet transformative Möglichkeiten in allen Branchen - von der intelligenten Fertigung und dem intelligenten Transportwesen bis hin zur Gesundheitsdiagnostik und autonomen Fahrzeugen - und ermöglicht lokale Datenverarbeitung, geringere Latenzzeiten, verbesserten Datenschutz und Entscheidungsfindung in Echtzeit.

InHand Networks widmet sich weiterhin der Weiterentwicklung des Edge-Intelligence-Ökosystems und ermöglicht Unternehmen weltweit, die Zukunft des intelligenten Edge-Computing zu nutzen.

Verwandte Produkte: