Ejecución del modelo destilado de DeepSeek R1 en computadoras InHand AI Edge

DeepSeek R1, un modelo de IA de código abierto, está redefiniendo la eficiencia y el rendimiento en la comunidad de IA. Su tecnología puntera de destilación del conocimiento transforma modelos complejos en potencias ligeras que ofrecen capacidades de inferencia de primer nivel. Esta combinación de accesibilidad de código abierto y diseño ligero está reduciendo las barreras a la implantación de la IA y abriendo nuevas posibilidades para la computación periférica.

El equipo de tecnología de IA de InHand Networks acaba de desplegar con éxito el modelo destilado DeepSeek R1 en la Ordenadores de vanguardia de IA de la serie EC5000. Este logro valida el potente potencial de los dispositivos de borde ligeros en tareas de inferencia de IA. En comparación con los despliegues tradicionales basados en la nube, la computación de borde de la IA elimina la necesidad de servidores de alto rendimiento, lo que permite la inferencia en tiempo real en entornos de bajo consumo. Esto hace que las soluciones de IA sean más flexible, segura y eficaz para aplicaciones como inspección de calidad industrial, transporte inteligente y telemedicina.

Ejecución del modelo DeepSeek R1 Distilled en los ordenadores EC5000 AI Edge

Con sólo unos pasos, puede implementar el modelo destilado DeepSeek R1 en los ordenadores de borde de la serie EC5000:

Paso 1: Instalar Jetson Containers Toolkit de Nvidia

(Este conjunto de herramientas ayuda a gestionar y desplegar eficazmente aplicaciones de IA en contenedores).

Ejecute los siguientes comandos para descargar e instalar el kit de herramientas Jetson Containers:

Paso 2: Instalar Nvidia JetPack Toolkit

(JetPack proporciona controladores y bibliotecas esenciales para ejecutar cargas de trabajo de IA en dispositivos impulsados por Jetson).

Para instalar el kit de herramientas JetPack, ejecute:

Espere aproximadamente un minuto antes de los siguientes pasos.

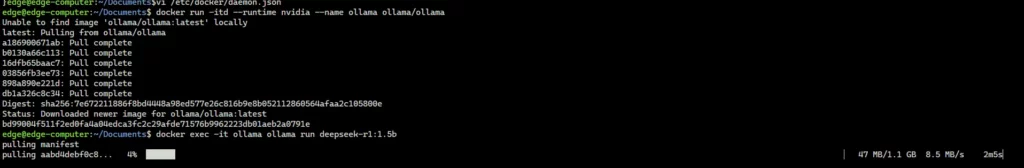

Paso 3: Descargar y ejecutar el contenedor Ollama

docker run -itd --runtime nvidia --name ollama ollama/ollama

Paso 4: Descargar y ejecutar el modelo DeepSeek R1 Distilled con Ollama

Referencia: Biblioteca DeepSeek R1

Seleccione el modelo destilado DeepSeek R1 apropiado de Biblioteca de Ollama e instalarlo automáticamente a través de la línea de comandos. Por ejemplo, para ejecutar el programa DeepSeek-R1-Distill-Qwen-1.5B modelo, ejecutar:

Puede sustituir deepseek-r1:1.5b por cualquier otro nombre de modelo disponible en Página de búsqueda de Ollama.

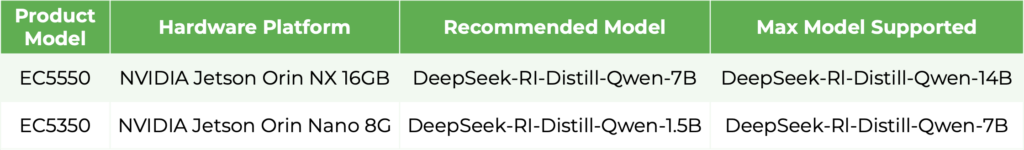

La siguiente tabla muestra los modelos destilados de DeepSeek R1 compatibles con los ordenadores de borde EC5000.

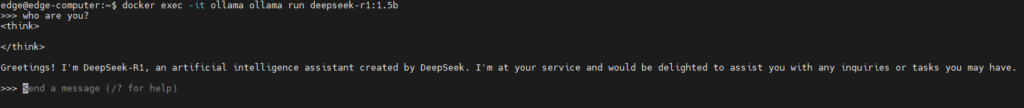

Interacción con el modelo

Una vez que el modelo se está ejecutando, puede interactuar con él directamente a través de la línea de comandos, lo que permite realizar consultas en tiempo real y obtener respuestas adaptadas a sus aplicaciones de IA específicas.

Nota: Sustituya "deepseek-r1:1.5b" por el nombre del modelo que desee utilizar, en función de sus requisitos específicos.

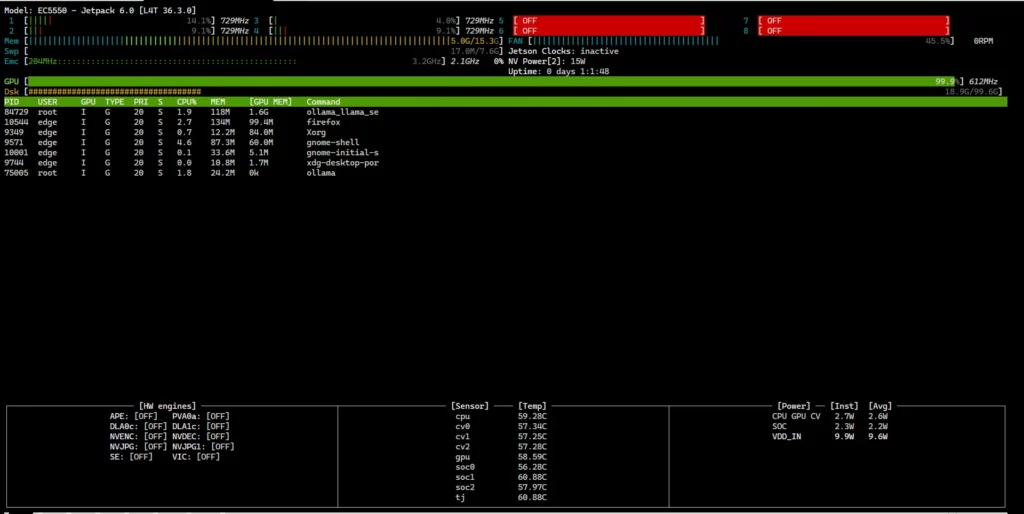

Supervisión de la utilización del hardware EC5000

Para comprobar el Uso de CPU, GPU y memoria de su ordenador EC5000 edge en tiempo real, utilice el jtop mando:

Esto mostrará el estado actual del hardware del dispositivo.

Importante: El comando jtop debe ejecutarse con privilegios de root.

Notas adicionales

- Además del modelo destilado DeepSeek R1, los ordenadores de borde de la serie EC5000 también admiten otros grandes modelos lingüísticos (LLM) de código abierto, tales como LLaMA 3.

- Ejecución de LLM en ordenadores de borde EC5000 a través de Ollama no es el único método disponible: pueden estudiarse otras opciones de implantación en función de sus necesidades específicas.

El despliegue del modelo destilado DeepSeek R1 en la serie EC5000 demuestra la perfecta integración de la IA de vanguardia con el hardware de computación de borde, allanando el camino para una nueva era de IA de borde ligera y de alto rendimiento.

A medida que la tecnología de destilación sigue evolucionando, las empresas pueden aprovechar estos avances para crear servicios privados de IA, reduciendo los costes informáticos y garantizando la seguridad de los datos. Este progreso abre oportunidades de transformación en todos los sectores, desde la fabricación inteligente y el transporte inteligente hasta el diagnóstico sanitario y los vehículos autónomos, permitiendo el procesamiento local de datos, la reducción de la latencia, la mejora de la privacidad de los datos y la toma de decisiones en tiempo real.

InHand Networks mantiene su dedicación al avance del ecosistema de inteligencia de borde, capacitando a las empresas de todo el mundo para adoptar el futuro de la computación de borde inteligente.

Productos relacionados: