InHand AIエッジコンピュータでDeepSeek R1蒸留モデルを実行する

オープンソースのAIモデルであるDeepSeek R1は、AIコミュニティの効率性とパフォーマンスを再定義しています。その最先端の知識蒸留技術は、複雑なモデルを軽量なパワーハウスに変換し、トップクラスの推論機能を提供します。オープンソースのアクセシビリティと軽量設計の組み合わせは、AI導入の障壁を下げ、エッジコンピューティングの新たな可能性を解き放ちます。

InHand NetworksのAI技術チームは、DeepSeek R1蒸留モデルの導入に成功した。 EC5000シリーズAIエッジコンピュータ.この成果は、AI推論タスクにおける軽量エッジデバイスの強力な可能性を証明するものです。従来のクラウドベースのデプロイメントと比較して、エッジAIコンピューティングは高性能サーバーの必要性を排除し、低消費電力環境でリアルタイムの推論を可能にします。これにより、AIソリューションはより 柔軟、安全、効率的 などの用途に使用される。 工業品質検査、インテリジェント輸送、遠隔医療.

EC5000AIエッジコンピュータでのDeepSeek R1蒸留モデルの実行

わずか数ステップで、EC5000シリーズのエッジコンピュータにDeepSeek R1蒸留モデルを展開できます:

ステップ1:NvidiaのJetson Containers Toolkitをインストールする。

(このツールキットは、コンテナ化されたAIアプリケーションを効率的に管理・展開するのに役立つ)。

以下のコマンドを実行し、Jetson Containersツールキットをダウンロードしてインストールします:

ステップ2:Nvidia JetPack Toolkitをインストールする

(JetPackは、Jetson搭載デバイス上でAIワークロードを実行するために不可欠なドライバとライブラリを提供する)。

JetPackツールキットをインストールするには、以下を実行する:

次のステップに移るまで約1分間待つ。

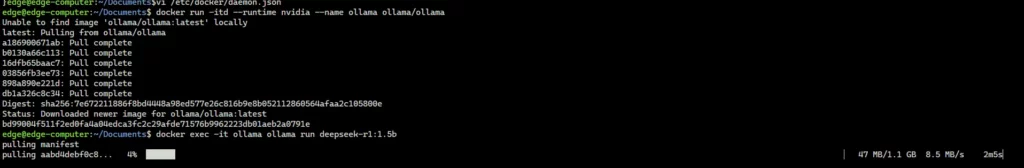

ステップ 3: Ollamaコンテナのダウンロードと実行

docker run -itd --runtime nvidia --name ollama ollama/ollama

ステップ 4: Ollama を使用した DeepSeek R1 Distilled モデルのダウンロードと実行

参考までに: DeepSeek R1 ライブラリ

から適切な DeepSeek R1 蒸留モデルを選択します。 オッラマの図書館 を実行し、コマンドラインで自動的にインストールする。例えば ディープシーク-R1-ディスティル-クウェン-1.5B モデル、実行:

deepseek-r1:1.5bは、次のモデル名で置き換えることができます。 Ollamaの検索ページ.

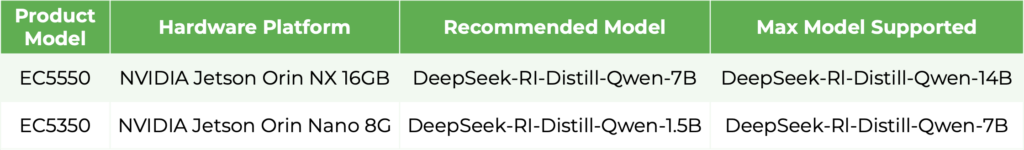

以下の表に、EC5000 エッジコンピュータでサポートされる DeepSeek R1 の蒸留モデルを示します。

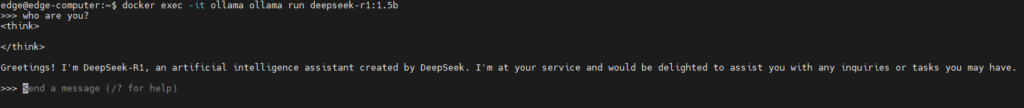

モデルとの対話

一旦モデルが実行されると、コマンドラインを通じてモデルと直接対話することができ、特定のAIアプリケーションに合わせたリアルタイムのクエリーと応答が可能になります。

注意事項: deepseek-r1:1.5b "は、特定の要件に基づいて、使用したいモデル名に置き換えてください。

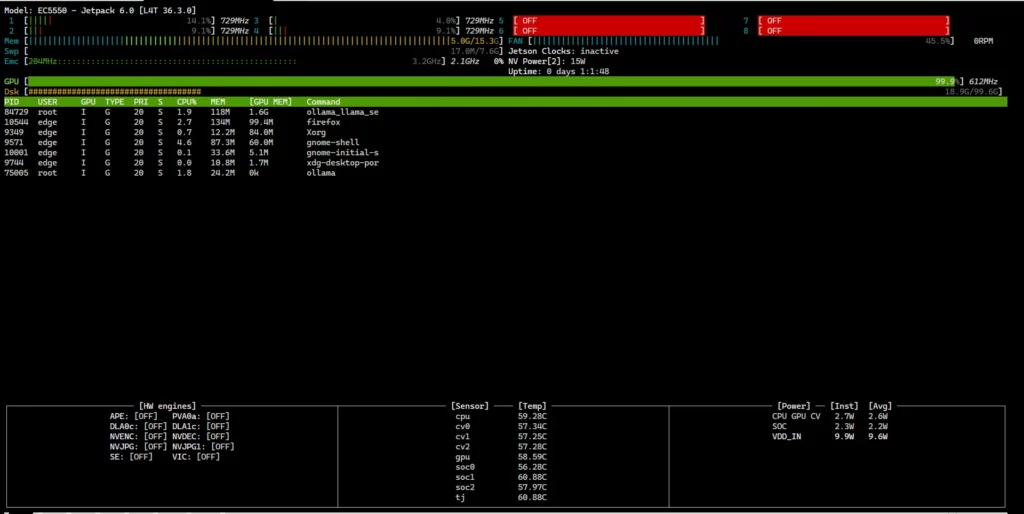

EC5000ハードウェアの使用状況の監視

を確認する。 CPU、GPU、メモリ使用量 を使用して、EC5000 エッジコンピュータをリアルタイムで制御します。 トップ コマンドを使用している:

これは、デバイスの現在のハードウェアステータスを表示します。

重要だ: jtopコマンドは ルート権限.

特記事項

- EC5000シリーズのエッジコンピュータは、DeepSeek R1蒸留モデルに加えて、以下のようなオープンソースの大規模言語モデル(LLM)もサポートしています。 LLaMA 3.

- EC5000エッジコンピュータでのLLMの実行 オーラマ 利用可能な方法はこれだけではありません。

EC5000シリーズにDeepSeek R1蒸留モデルを導入することで、最先端AIとエッジコンピューティング・ハードウェアのシームレスな統合が実証され、軽量で高性能なエッジAIの新時代への道が開かれます。

蒸留技術が進化し続ける中、企業はこれらの進歩を活用してプライベートAIサービスを構築し、データセキュリティを確保しながらコンピューティングコストを削減することができます。この進歩は、スマート製造やインテリジェント輸送から、ヘルスケア診断や自律走行車まで、業界全体の変革の機会を解き放ち、ローカルデータ処理、待ち時間の短縮、データプライバシーの強化、リアルタイムの意思決定を可能にする。

InHand Networksは、エッジインテリジェンスエコシステムの発展に専心し、世界中の企業がインテリジェントエッジコンピューティングの未来を受け入れられるよう支援しています。

関連製品: